Protocollo, non Modello.

Immagina un assistente AI che non solo ti risponde, ma prenota un viaggio, conferma le policy aziendali, scrive un’email coerente con il tono del tuo brand e allinea i dati di marketing con i tuoi obiettivi trimestrali. Non perché è un supermodello, ma perché sa dove andare a cercare le informazioni, in tempo reale, da fonti affidabili e strutturate.

Benvenuti nel mondo del Model Context Protocol (MCP). Non è un nuovo modello. È il nuovo modo in cui gli agenti AI diventano davvero utili.

Nel vasto panorama dell’AI generativa, non basta più avere modelli linguistici potenti. Serve un ecosistema che li renda consapevoli, contestuali e collaborativi.

Cos’è MCP: il nuovo “router semantico” dell’AI.

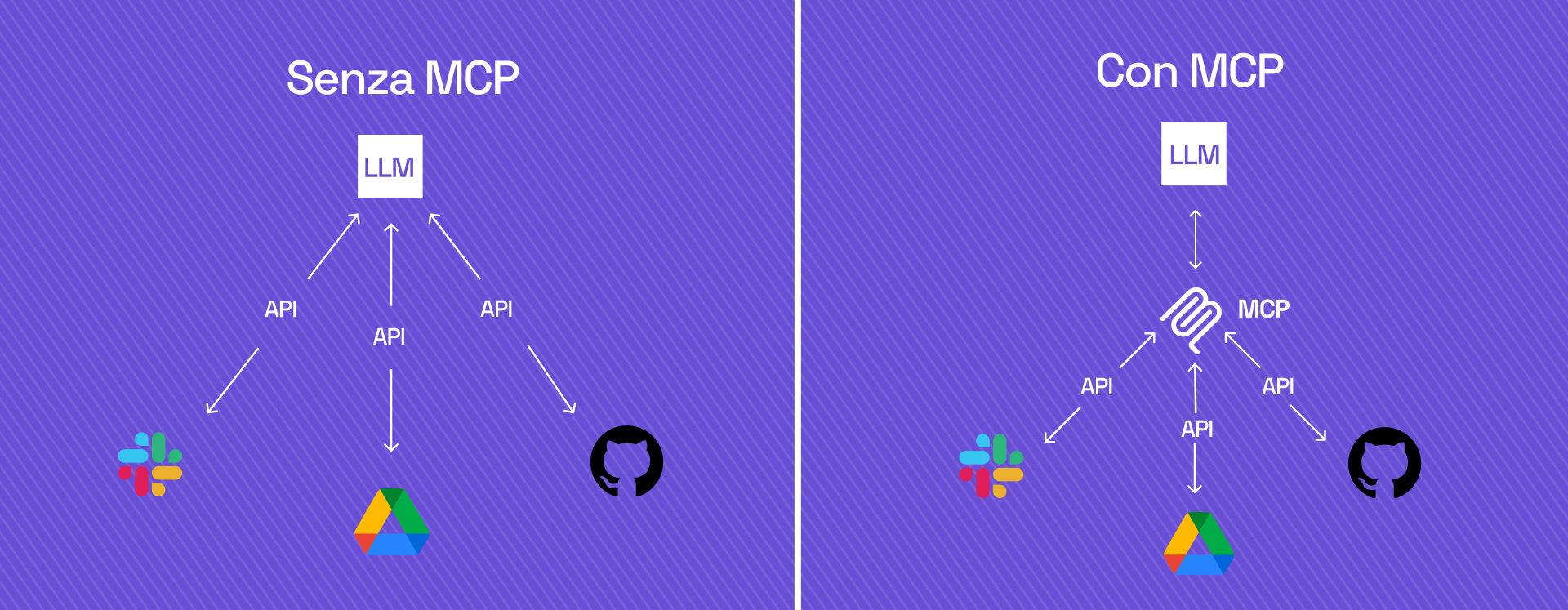

MCP è un protocollo aperto che definisce come fornire “contesto” a un Large Language Model (LLM), in altre parole come metterlo nelle condizioni di capire, interpretare e agire sulla base di dati aggiornati, strutturati, verificabili. È come passare da una conversazione cieca, fatta solo di prompt, a un dialogo informato.

In pratica:

- L’applicazione (host) si connette a una rete di MCP Server, ognuno dei quali espone dati o documenti in formato standard.

- Il MCP Client (tipicamente il LLM o il suo orchestratore) chiede solo ciò che serve, nel momento esatto in cui serve.

- Il contesto diventa accessibile, interrogabile, sicuro.

Perché MCP cambia le regole del gioco.

Chi lavora con gli LLM sa che questi modelli di linguaggio, per quanto potenti, hanno dei limiti.

Ecco i vantaggi chiave:

- Standard universale: un unico formato per qualsiasi sorgente di contesto.

- Open e interoperabilità: chiunque può implementare un server MCP o connettersi a uno esistente.

- Efficienza: il modello non deve più portare tutto “dentro di sé”. Chiede solo ciò che serve, quando serve.

3 ruoli fondamentali.

Per capire MCP, servono tre concetti chiave:

- MCP Server → la sorgente di contesto. Espone i dati tramite API standardizzate.

- MCP Client → chi consuma il contesto. Di solito il modello o l’agente AI.

- MCP Host → l’applicazione che funge da intermediario. Può orchestrare client e server, anche da diversi ambienti.

Insieme, creano un ecosistema distribuito, dove il contesto fluisce in modo sicuro e modulare

Non è un altro LLM. È il suo alleato più potente.

MCP non è un modello, né un sostituto. È un protocollo di collaborazione.

Gli LLM sono bravi a ragionare, sintetizzare, generare. Però non accedono a dati aggiornati, non ricordano, e talvolta inventano.

MCP permette agli LLM di:

- Connettersi a fonti in tempo reale

- Ottenere dati personalizzati, contestuali e verificati

- Mantenere una coerenza operativa tra più richieste

Da prompt a azione. In pratica, un LLM connesso a un MCP diventa un agente.

Non più solo un generatore di testi, ma un collettore attivo di informazioni, capace di muoversi tra fonti diverse e agire in base a esse.

MCP in azione: i primi esploratori e i loro vantaggi.

Un nuova ondata di bigtech come Anthropic e di sviluppatori indipendenti sono stati tra i primi a scommettere sul Model Context Protocol. Non come esperimento, ma come leva concreta per costruire agenti AI realmente operativi.

Per queste realtà, adottare MCP ha significato liberare l’AI dai suoi silos: niente più modelli chiusi o workflow rigidi, ma una rete flessibile di fonti, aggiornata in tempo reale, che alimenta agenti precisi, sicuri, contestuali.

I risultati?

- Agenti che leggono documentazione tecnica e generano insight affidabili

- Assistenti personali che incrociano calendari e brief, e suggeriscono azioni puntuali

- Sistemi di supporto che rispondono alle policy aziendali più aggiornate, senza allucinazioni

In tutti i casi, MCP ha potenziato l’efficacia e la velocità delle risposte, offrendo un vantaggio competitivo tangibile: l’AI non solo “parla”, ma agisce con consapevolezza.

Sicurezza: fidarsi è bene, protocollare è meglio.

Un protocollo di questo tipo non può prescindere dalla sicurezza dei dati. MCP è progettato con una gestione rigorosa degli accessi:

- l’autenticazione è sempre richiesta

- tracciata

- ogni interazione può essere loggata e verificata.

Questo consente alle aziende di condividere il contesto con l’AI senza esporre informazioni sensibili, mantenendo il pieno controllo su cosa viene interrogato e da chi.

RAG vs MCP: due approcci a confronto.

RAG è una tecnica che permette ai LLM di recuperare documenti da motori di ricerca o database vettoriali per poi generarne risposte.

MCP, invece, è un protocollo aperto e modulare che standardizza l’accesso a fonti di contesto tramite server remoti, rendendo i modelli più flessibili e interoperabili.

A differenza di RAG, spesso vincolato a un motore specifico, MCP consente di connettere più fonti strutturate in tempo reale, con sicurezza avanzata, maggiore modularità e scalabilità. Inoltre, è API-first, pensato per integrazioni rapide e agenti dinamici. MCP può anche incorporare RAG al suo interno, rendendo il retrieval una parte modulare di un sistema più orchestrabile e potente.

Verso un’AI agentica e cooperativa.

Il Model Context Protocol segna la fine dell’AI chiusa in se stessa. Non serve più costruire il modello più grande. Serve mettere in rete le intelligenze.

MCP abilita un ecosistema distribuito, flessibile, agentico:

- Un’AI che non solo elabora, ma comprende.

- Che non solo risponde, ma agisce.

- Che non vive isolata in un prompt, ma si muove tra contesti reali, in tempo reale.

Per chi progetta il futuro del marketing, della strategia o dell’AI generativa, MCP è il nuovo layer operativo. Il minimo comune denominatore per costruire intelligenze cooperative, connettive, realmente utili.

Benvenuti nell’era del Contesto come Servizio. Dove l’AI non si limita a generare. Collabora.